En el vertiginoso mundo de la Inteligencia Artificial, donde los Modelos de Lenguaje Grandes (LLMs) como ChatGPT y GPT-4 han revolucionado nuestra interacción con la tecnología, surge una pregunta crucial: ¿realmente razonan estas máquinas? La respuesta, sorprendentemente, es no. Sin embargo, una nueva arquitectura de IA diminuta está cambiando el juego, inspirada directamente en la forma en que nuestro propio cerebro humano aborda el razonamiento secuencial.

Un grupo de investigadores ha desarrollado el Hierarchical Reasoning Model (HRM), un modelo con tan solo 27 millones de parámetros, entrenado con apenas 1000 ejemplos, que ha logrado superar a modelos masivos como GPT-3 en benchmarks de razonamiento como ARC AGI, resolviendo complejos Sudokus y laberintos. Su logro es tan significativo que ya se habla de él como uno de los papers más importantes en el campo de la IA.

El Talón de Aquiles de los LLMs Actuales: Predicción vs. Razonamiento

Modelos basados en la arquitectura Transformer, como Chat GPT, son excelentes para imitar el lenguaje natural, pero presentan problemas en tareas que requieren razonamiento secuencial. Yann LeCun, una de las figuras prominentes de la IA, ha señalado que la capacidad de imitar el lenguaje no equivale a un verdadero razonamiento.

Cuando le pides a un LLM que calcule, por ejemplo, «23 * 28», internamente no sigue un proceso secuencial dígito por dígito como lo haría un humano. En su lugar, realiza una serie de cálculos para predecir el resultado más probable basándose en los datos con los que fue entrenado. Si ha visto esa operación y su resultado (644) en sus datos de entrenamiento, es muy probable que lo acierte. Pero si le preguntas una multiplicación que nunca antes ha visto, su predicción podría ser incorrecta, evidenciando que no razona, solo predice.

Para intentar compensar esta limitación, los laboratorios han introducido técnicas como la «Chain of Thought» (CoT) o «cadena de pensamiento». Esta estrategia permite que el modelo «piense en voz alta» o «hable consigo mismo» internamente antes de dar una respuesta, intentando simular un proceso de pasos. Sin embargo, los creadores del HRM critican la CoT como una «solución insatisfactoria» y un mero «parche» que no resuelve el problema fundamental de que estos modelos son, en esencia, máquinas de predicción, no de razonamiento lógico y secuencial. Además, la CoT a menudo sufre de una «descomposición frágil de tareas» y requiere grandes cantidades de datos.

HRM: La Inspiración en el Cerebro Humano para el Verdadero Razonamiento Secuencial

El Hierarchical Reasoning Model rompe con este paradigma al inspirarse directamente en la arquitectura jerárquica y de múltiples escalas temporales del cerebro humano. Nuestro cerebro opera con diferentes tipos de ondas y neuronas que se encargan de distintas funciones:

- Neuronas de Alto Nivel (High-level): Ubicadas en el córtex prefrontal, operan más lento y se encargan de crear abstracciones, estrategias y planes a largo plazo. Piensa en ellas como el «arquitecto» de nuestro cerebro.

- Neuronas de Bajo Nivel (Low-level): Funcionan a una frecuencia más alta y procesan detalles sensoriales inmediatos, acciones motoras y tareas que requieren velocidad. Son el «ingeniero» que ejecuta los planes.

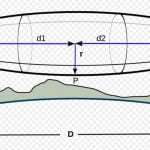

Estas dos partes tienen una relación bidireccional, comunicándose constantemente. El HRM imita esto con dos módulos interdependientes:

- El módulo de alto nivel (H), encargado de la estrategia, no se ejecuta constantemente.

- El módulo de bajo nivel (L), encargado de los detalles y el cómputo, sí se ejecuta de forma continua.

Imagina la construcción de un edificio: el arquitecto (módulo H) define el plano general, y el ingeniero (módulo L) ejecuta la construcción piso por piso. El ingeniero trabaja constantemente, y solo después de completar una fase (un ciclo o conjunto de «timesteps»), el arquitecto interviene para revisar el progreso, comparar con el plan original y actualizar la estrategia si es necesario. Este proceso iterativo de «estrategia, ejecución, revisión y actualización» permite al HRM abordar tareas complejas que requieren múltiples pasos secuenciales, como resolver un Sudoku o un laberinto.

Innovaciones Clave del HRM:

El HRM incorpora varias mejoras cruciales para su capacidad de razonamiento:

- Proceso Recurrente Mejorado: A diferencia de arquitecturas previas como las Redes Neuronales Recurrentes (RNNs) que tienden a converger demasiado rápido y «dejar de pensar» de manera efectiva, el HRM mantiene una distribución continua y lineal de la actividad, asegurando que cada «pensamiento» contribuya a la solución final.

- Gestión Eficiente de Memoria: El HRM evita la necesidad de memorizar todos los pasos previos (un problema de las RNNs con «back propagation through time» que consume mucha memoria). En cambio, solo aprende en los pasos finales, haciendo el proceso mucho más eficiente.

- Supervisión Profunda (Deep Supervision): Los problemas se dividen en pequeños segmentos o fases, y el modelo aprende y se supervisa en cada uno de estos segmentos. Esto es análogo a aprender a construir un edificio fase por fase (cimientos, tuberías, etc.), lo que permite un aprendizaje de errores más preciso y robusto en procesos secuenciales.

- Tiempo de Cómputo Adaptativo (Adaptive Compute Time – ACT): Una característica distintiva del HRM es su capacidad para decidir cuándo detener su razonamiento o cuándo continuar. Al igual que un humano, el modelo puede estimar cuánto esfuerzo mental requiere un problema y saber cuándo ha llegado a una solución satisfactoria. Esto optimiza enormemente el cómputo, logrando un rendimiento casi idéntico con mucho menos consumo de recursos que modelos con un número de pasos prefijado.

Resultados Asombrosos y el Camino Hacia la AGI

Los resultados del HRM son verdaderamente impresionantes:

- Tamaño y Eficiencia: Con solo 27 millones de parámetros y 1000 ejemplos de entrenamiento, el HRM es increíblemente pequeño y eficiente, especialmente si se compara con los 200 mil millones de parámetros de GPT-3.

- Rendimiento Superior: Logra un rendimiento casi perfecto en tareas desafiantes como complejos Sudokus y encontrar rutas óptimas en grandes laberintos. Además, supera a modelos mucho más grandes en el Abstraction and Reasoning Corpus (ARC), un benchmark clave para la Inteligencia General Artificial (AGI).

- Exploración de Caminos: Al resolver un laberinto, el HRM explora diferentes caminos hasta llegar a la solución, un algoritmo secuencial similar al que seguiría un humano o una máquina inteligentemente diseñada.

Los investigadores incluso han encontrado similitudes en la «riqueza de representaciones neuronales» (medida por el «participation ratio») entre el HRM y cerebros de animales como los ratones, donde las zonas asociadas a la planificación (módulo high) tienen una mayor capacidad de generalización que las zonas sensoriales (módulo low). Aunque esta evidencia es correlacional y no causal, sugiere una prometedora alineación con principios biológicos.

El Futuro del Razonamiento en la IA

El Hierarchical Reasoning Model representa un avance transformador hacia la computación universal y los sistemas de razonamiento de propósito general. Al aprender a «pensar» de manera secuencial y adaptativa, y al hacerlo con una eficiencia sin precedentes, el HRM no solo supera las limitaciones de los LLMs actuales en tareas de razonamiento, sino que también nos acerca a una IA que comprende y aborda los problemas de una manera más fundamentalmente inteligente.

Si te interesa profundizar, puedes explorar el repositorio de GitHub de los autores y los checkpoints de los modelos en Hugging Face, donde se explica cómo empezar a usar esta revolucionaria arquitectura.